Métodos de ordenamento

Um array do NumPy pode ser ordenado com o método array.sort(), que transforma o array inplace. Se o array que passa por ordenamento for uma seção (uma view ) de um array maior esse array original também será alterado. O método np.sort(array) retorna cópia ordenada, sem alterar o original. Não há um método ou parâmetro predefinido para fazer o ordenamento inverso. Para isso usamos a mesma sintaxe que retorna uma lista invertida, lista[::-1].

» # um array qualquer sem ordenamento » arrOriginal = np.array([-1, 20, 13, -5, 1, 0, 9, 3, -3, 7]) » # uma cópia (não uma view) » arr = arrOriginal.copy() » # arr.sort ocorre inplace » arr.sort() » arr ↳ array([-5, -3, -1, 0, 1, 3, 7, 9, 13, 20]) » # para obter a lista ordenada invertida (sem alterar a original) » arr[::-1] ↳ array([20, 13, 9, 7, 3, 1, 0, -1, -3, -5]) » # retorna para o array original (não ordenado) » arr = arrOriginal.copy() » np.sort(arr) ↳ array([-5, -3, -1, 0, 1, 3, 7, 9, 13, 20]) » # arr não foi alterado » arr ↳ array([-1, 20, 13, -5, 1, 0, 9, 3, -3, 7]) » # o array ordenada em ordem inversa também pode ser obtido (inplace) da seguinte forma » arr[::-1].sort() » arr ↳ array([20, 13, 9, 7, 3, 1, 0, -1, -3, -5])

Para arrays como mais de um eixo podemos informar ao longo de qual deles queremos ordenar os valores. Em qualquer dos casos cada linha (ou cada coluna) será ordenada independentemente. Em qualquer dos casos, com o ordenamento das colunas, as linhas perdem seu alinhamento, caso exista. Por exemplo, se cada linha se referia à uma medida específica, no ordenamento os dados ficam desalinhados. Idem para ordenamento das linhas.

» # inicializamos um array 3 × 4

» lista = ([ [ 3, 2, 1, -1],

[-3, 4, -6, 5],

[ 3, 0, -9, 15]

])

» arr = np.array(lista)

» arr

↳ array([[ 3, 2, 1, -1],

[-3, 4, -6, 5],

[ 3, 0, -9, 15]])

» # ordenamos ao longo das colunas

» arr.sort(0)

» arr

↳ array([[-3, 0, -9, -1],

[ 3, 2, -6, 5],

[ 3, 4, 1, 15]])

» # reconstituindo o array original

» arr = np.array(lista)

» # ordenamos ao longo das linhas

» arr.sort(1)

» arr

↳ array([[-1, 1, 2, 3],

[-6, -3, 4, 5],

[-9, 0, 3, 15]])

Gravação e leitura de arrays em arquivos

Em muitas situações é útil gravar resultados finais ou etapas intermediárias de cálculo para posterior finalização. NumPy permite a gravação de arquivos contendo os arrays em formato de texto ou binário. Os métodos principais são np.save() e np.load(). Por default um array é gravado em arquivo com extensão .npy em formato binário. Formatos mais sofisticados para textos e arrays tabulares são encontrados no pandas.

» # criando um array

» arr = np.linspace(0, 22, 12).reshape(3,4)

» arr

↳ array([[ 0., 2., 4., 6.],

[ 8., 10., 12., 14.],

[16., 18., 20., 22.]])

» # esse array será gravado em arrGravado.npy.

» # a extensão será acrescentada se não fornecida

↳ np.save('arrGravado', arr)

» # apagamos o array e depois o recarregamos

» del arr

» arr = np.load('arrGravado.npy')

» arr

↳ array([[ 0., 2., 4., 6.],

[ 8., 10., 12., 14.],

[16., 18., 20., 22.]])

Mais de um array podem ser gravados no mesmo arquivos arq.npz. Os arrays são passados como argumentos de keyword. Na recuperação dos arrays um objeto tipo dicionário é carregado, tendo os arrays associados às chaves que foram as keywords passadas.

A mesma operação de armazenar vários arrays em arquivo pode ser realizada compactando-se os dados para que ocupem menos espaço em disco. Isso é feito com np.savez_compressed('nomeDoArquivoaCompactado.npz', a=arr1, b=arr2, ...).

» # definimos 2 arrays

» arr1 = np.array([1,2,3])

» arr2 = np.array([4,5,6])

» # e os gravamos em disco

» np.savez('variosArrays.npz', a1=arr1, a2=arr2)

» # apagamos e recuperamos os arrays

» del arr1, arr2

» arrays = np.load('variosArrays.npz')

» # o load carrega um objeto tipo dicionário

» arr1, arr2 = arrays['a1'], arrays['a2']

» display(arr1, arr2)

↳ array([1, 2, 3])

↳ array([4, 5, 6])

» # a mesma operação, amazenando os arrays em arquivo compactado

» np.savez_compressed('arraysCompactados.npz', a=arr1, b=arr2)

Métodos de conjuntos

Algumas operações básica podem ser aplicadas sobre arrays, tratando seus elementos como um conjunto. Uma delas, usada com frequência, é a seleção de elementos únicos no array, feita com np.unique. O método np.in1d(array, valores), testa se elementos de um array estão também em outro, retornando um array booleano. O objeto valores pode ser uma lista, tupla ou outro array unidimensional.

» arr = np.array([1,2,3,4,4,3,2,1]) » # elementos de arr sem repetições » np.unique(arr) ↳ array([1, 2, 3, 4]) » arrString = np.array(['Ana','Luiz','Paulo','Ana','Otto','Paulo','Otto','Paulo']) » np.unique(arrString) ↳ array(['Ana', 'Luiz', 'Otto', 'Paulo'], dtype='<U5') » # quais dos elementos de arr estão em (1,3,5) » np.in1d(arr, (1,3,5)) ↳ array([ True, False, True, False, False, True, False, True]) » # o argumento pode ser uma tupla, lista ou array » teste = np.array([1,3,5]) » np.in1d(arr, teste) ↳ array([ True, False, True, False, False, True, False, True]) » # o mesmo com array de strings » txt = np.array(['Otto','Luiz','Ana']) » np.in1d(arrString, txt) ↳ array([ True, True, False, True, True, False, True, False]) » arrString = np.array(['A','F','D','A','O','P','C','D']) » lista = np.in1d(arrString, ['A', 'B', 'C']) » # os seguintes elementos estão na lista » arrString[lista] ↳ array(['A', 'A', 'C'], dtype='<U1') » # os seguintes elementos não estão na lista » arrString[~lista] ↳ array(['F', 'D', 'O', 'P', 'D'], dtype='<U1')

O método np.intersect1d(x, y) retorna a interseção entre x e y.

O método np.setdiff1d(x, y) retorna x-y.

setxor1d(x, y): elementos em x ou y, mas não em ambos.

» # para verificar intersect1d » # múltiplos de 23 até 1000 » arr1 = np.arange(0,1000,23) » # múltiplos de 27 até 1000 » arr2 = np.arange(0,1000,27) » # múltiplos de 23 e 27 até 1000 (é a interseção entre os dois conjuntos) » np.intersect1d(arr1, arr2) ↳ array([ 0, 621]) » # para verificar setdiff1d » arr1 = np.array([5, 3, 1, 9, 7, 6]) » arr2 = np.array([5, 4, 1, 8, 2, 3]) » np.setdiff1d(arr1,arr2) ↳ array([6, 7, 9]) » # para verificar setxor1d » np.setxor1d(arr1,arr2) ↳ array([2, 4, 6, 7, 8, 9])

Funções de conjuntos em NumPy:

| Método | descrição |

|---|---|

unique(x) |

conjunto de elementos únicos em x, |

intersect1d(x, y) |

elementos comuns em x e y, (ordenados), |

union1d(x, y) |

união dos elementos em x e y, (ordenados), |

in1d(x, y) |

array booleano indicando se cada elemento de x está em y, |

setdiff1d(x, y) |

conjunto diferença: elementos em x que não estão em y, |

setxor1d(x, y) |

conjunto diferença simétrica: elementos em x ou y, mas não em ambos. |

Numpy: Álgebra linear

A Álgebra Linear é uma parte da matemática muito importante nas aplicações científicas e da engenharia. Para o cálculo simbólico o módulo Sympy (Matemática Simbólica em Python) oferece muitos métodos interessantes e úteis, inclusive para a álgebra linear.

É uma notação útil denotar os arrays da seguinte forma:

Um array unidimensional (um vetor) é uma coleção de elementos \(A_M = \{a_{i}\}\), onde \(i = 0, …,M-1\) para um array de rank = 1. Diferente da notação matemática usual os índices são contados a partir de 0. Seu shape = (M,).

Um array bidimensional (uma matriz) é uma coleção de elementos \(A_{MN} = \{a_{ij}\}\) onde \(i = 0, …,M-1; j = 0, …,N-1; \) para um array de rank = 2. Seu shape=(M,N) e rank=2.

Arrays de ranks superiores são generalizações, com mais eixos acresentados. Em arrays 3-dimensionais, digamos arr3D.shape = (r,m,n), temos r matrizes m × n.

Arrays de ranks superiores são generalizações, com mais eixos acresentados. Em arrays 3-dimensionais, digamos arr3D.shape = (r,m,n), temos r matrizes m × n.

Alguns dos métodos mais comuns usados na álgebra linear estão no módulo numpy.linalg, descrito abaixo.

Produto Matricial

O produto de matrizes, que é diferente da operação * definida previamente e que consiste na mera multiplicação dos termos e/e, está definido em numpy. As dimensões devem ser compatíveis. Por exemplo, o produto

Am,n × Bn,p = Cm,p. A sintaxe do produto de matrizes A por B é np.dot(A,B) ou A.dot(B).

» # produto matricial

» A = np.arange(0, 9).reshape(3, 3)

» B = np.arange(0, 3).reshape(3, 1)

» A

↳ array([[0, 1, 2],

[3, 4, 5],

[6, 7, 8]])

» B

↳ array([[0],

[1],

[2]])

» A * B

↳ array([[ 0, 0, 0],

[ 3, 4, 5],

[12, 14, 16]])

» A + B

↳ array([[ 0, 1, 2],

[ 4, 5, 6],

[ 8, 9, 10]])

» A.dot(B) # o mesmo que np.dot(A,B)

↳ array([[ 5],

[14],

[23]])

» # 6 *0 + 7*1 + 8*2 = 23 # é o elemento da 3º linha do produto

» # B.dot(A) não está definida

» # O quadrado da matriz A, A2 = A.dot(A)

» A.dot(A)

↳ array([[ 15, 18, 21],

[ 42, 54, 66],

[ 69, 90, 111]])

Matemáticamente a operação acima para \(A \cdot B\) (A.dot(B)) é representada como:

$$

\left[ \begin{array}{ccc}

0 & 1 & 2\\

3 & 4 & 6\\

6 & 7 & 8

\end{array} \right] \left[ \begin{array}{c}

0\\

1\\

2

\end{array} \right] = \left[ \begin{array}{l}

5\\

14\\

23

\end{array} \right] .

$$

Transposta e inversões de eixos

A tansposta de uma matriz é a matriz obtida da original trocando-se suas linhas por colunas. Essa é uma operação comum na análise de dados e na álgebra linear e pode ser obtida com o método transposta = array.transpose() ou seu atalho transposta = array.T. Em notação matemática, se \(A_{MN} = \{a_{ij}\}\) sua transposta é \(A{^T}_{NM} = \{a_{ji}\}\).

» import numpy as np

» # uma matriz (2 ×3 ) qualquer para exemplo

» arr = np.arange(0,6).reshape(2,3)

» arr

↳ array([[0, 1, 2],

[3, 4, 5]])

» # sua transposta é (3 × 2)

» transp = arr.T

» transp

↳ array([[0, 3],

[1, 4],

[2, 5]])

» # o produto matricial (dot) é (2 × 2)

» np.dot(arr,transp)

↳ array([[ 5, 14],

[14, 50]])

» # observe que o produto não é comutativo

» # (a ordem é relevante) transp.arr é (3 × 3)

» np.dot(transp, arr)

↳ array([[ 9, 12, 15],

[12, 17, 22],

[15, 22, 29]])

Em matrizes de ordem superior a operação de transposição permite que se informe quais os eixos serão transpostos. Um array arr3D do exemplo abaixo, com shape = (2,3,4), que pode ser vista como 2 matrizes 3 × 4 se torna um array com 3 matrizes 2 × 4 através da operação arr3D.transpose(1,0,2), onde o 1º eixo é permutado com o 2º (o 3º fica inalterado).

» arr3D = np.arange(24).reshape((2, 3, 4))

» arr3D

↳ array([[[ 0, 1, 2, 3],

[ 4, 5, 6, 7],

[ 8, 9, 10, 11]],

[[12, 13, 14, 15],

[16, 17, 18, 19],

[20, 21, 22, 23]]])

» # permutando 1º eixo com o 2º

» arr3D.transpose(1,0,2)

↳ array([[[ 0, 1, 2, 3],

[12, 13, 14, 15]],

[[ 4, 5, 6, 7],

[16, 17, 18, 19]],

[[ 8, 9, 10, 11],

[20, 21, 22, 23]]])

» # temos 3 matrizes 2 × 4

» arr3D.transpose(1,0,2).shape

↳ (3, 2, 4)

» # se permutarmos 2º com 3º eixo

» arr3D.transpose(0,2,1)

↳ array([[[ 0, 4, 8],

[ 1, 5, 9],

[ 2, 6, 10],

[ 3, 7, 11]],

[[12, 16, 20],

[13, 17, 21],

[14, 18, 22],

[15, 19, 23]]])

No último caso, permutando 2º com 3º eixo e mantendo o 1º temos as 2 matrizes original transpostas.

A transposição é um caso particular da inversão mais geral de eixos. Isso pode ser feito com array.swapaxes(i,j), que recebe um par de índices referentes aos eixos e os permuta.

» # ainda usando a matriz já definida

» arr3D

↳ array([[[ 0, 1, 2, 3],

[ 4, 5, 6, 7],

[ 8, 9, 10, 11]],

[[12, 13, 14, 15],

[16, 17, 18, 19],

[20, 21, 22, 23]]])

» arr3D.swapaxes(0,2)

↳ array([[[ 0, 12],

[ 4, 16],

[ 8, 20]],

[[ 1, 13],

[ 5, 17],

[ 9, 21]],

[[ 2, 14],

[ 6, 18],

[10, 22]],

[[ 3, 15],

[ 7, 19],

[11, 23]]])

arr3D.swapaxes(0,2) é idêntica à arr3D.transpose(2,1,0). Quando as dimensões são altas pode ficar difícil visualizar e manipular os arrays. Em alguns casos quebrar o array em blocos pode ser a melhor prática.

Biblioteca numpy.linalg

numpy.linalg é uma subbiblioteca de NumpPy contendo métodos matriciais usuais as operações comuns na álgebra linear, como o cálculo de determinantes e de matrizes inversas similares àquelas usadas no MATLAB e R.

Alguns dos métodos mais comuns usados na álgebra linear:

| Método | descrição |

|---|---|

diag |

elementos da diagonal (ou fora da diagonal) de matriz quadrada, |

diag |

Se o argumento for array 1-D retorna o array na diagonal e zeros fora da diagonal, |

dot |

multiplicação de matrizes, |

trace |

traço: soma dos elementos da diagonal, |

det |

determinante da matriz, |

eig |

autovalores e autovetores (eigenvalues e eigenvectors) de uma matriz quadrada, |

inv |

a inversa de uma matriz quadrada, |

pinv |

a pseudo inversa de Moore-Penrose de uma matriz, |

qr |

cálculo da decomposição QR, |

svd |

calcula a decomposição de valor singular (SVD), |

solve |

resolve o sistema linear Ax = b para x, sendo A uma matriz quadrada, |

lstsq |

calcula a solução de mínimos quadrados para Ax = b. |

A solução de sistemas lineares é uma aplicação comum da álgebra linear. Um exemplo bem simples com equações e 2 incógnitas, cuja solução pode ser vista em matrizes, é:

$$

\left\{ \begin{array}{l}

2 x + y = 5\\

x – 3 y = 6

\end{array} \right.

$$

Ele corresponde a busca do array x (um vetor de 2 variáveis) satisfazendo A x = B onde A e B são listados abaixo.

» A = np.array([[2, 1], [1, -3]]) » B = np.array([5, 6]) » x = np.linalg.solve(A, B) » # a solução é » x ↳ array([ 3., -1.])

Portanto a solução (única, nessa caso) é o vetor \(x = (3., -1.)\).

Dada uma matriz \(A\), por definição sua matriz inversa é \(A^{-1}\), satisfazendo \(A.A^{-1} = A^{-1}.A = I\), onde \(I\) é a matriz identidade. Observe que um sistema do tipo \(A.x = B\) fica resolvido se existe a inversa, \(A^{-1}\). Nesse caso basta multiplicar todo o sistema à esquerda (ou à direita) pela inversa: \(A^{-1}.A.x = A^{-1}.B\) que resulta na solução procurada \(x = A^{-1}.B\).

Para o mesmo sistema acima:

» from numpy.linalg import inv

» A = np.array([[2, 1], [1, -3]])

» B = np.array([5, 6])

» # a inversa de A é

» inv(A)

↳ array([[ 0.42857143, 0.14285714],

[ 0.14285714, -0.28571429]])

» # por definição A . inv(A) = identidade †

» # (verificamos que essa é de fato a inversa)

» np.dot(A, inv(A)).round(2)

↳ array([[1., 0.],

[0., 1.]])

» # a solução do sistema é

» np.dot(inv(A), B)

↳ array([ 3., -1.])

(†): Não se pode esperar que de fato o cálculo de A.inv(A) resulte exatamente na identidade. Devido à aproximações numéricas essa matriz apresentará com frequência elementos pequenos mas não nulos fora da diagonal. Daí o uso de .round(2).

Algumas matrizes não possuem inversas, sendo chamadas de matrizes singular. Seu determinante é \(det(A)= 0\) e, nesse caso, o sistema não tem solução.

» # resolvendo o sistema » A = np.array([[2, 1], [6, 3]]) » B = np.array([5, 10]) » x = np.linalg.solve(A, B) ↳ LinAlgError: Singular matrix # ocorre que a matriz A é singular, e o sistema não tem solução » det(A) ↳ 0.0

O determinante de uma matriz \(A\), denotada por \(det(A)\) está definido no artigo sobre determinantes, nesse site. O exemplo abaixo está resolvido nessa página. Como \(det(A)\ne 0\) ela possui uma inversa \(A^{-1}\), definida de forma que \(A.A^{-1} = \mathbb{I}\), onde \(\mathbb{I}\) é a matriz identidade.

» arr = np.array([[1, -2, 3],[2, 1, -1], [-2, -1, 2]])

» arr

↳ array([[ 1, -2, 3],

[ 2, 1, -1],

[-2, -1, 2]])

» np.linalg.det(arr).round(2)

↳ 5.0

» np.linalg.inv(arr)

↳ array([[ 0.2, 0.2, -0.2],

[-0.4, 1.6, 1.4],

[ 0. , 1. , 1. ]])

» # A A-1 é a identidade

» np.dot(arr,inv(arr))

↳ array([[1., 0., 0.],

[0., 1., 0.],

[0., 0., 1.]])

» # A A-1 é a identidade

» np.dot(arr,inv(arr))

↳ array([[1., 0., 0.],

[0., 1., 0.],

[0., 0., 1.]])

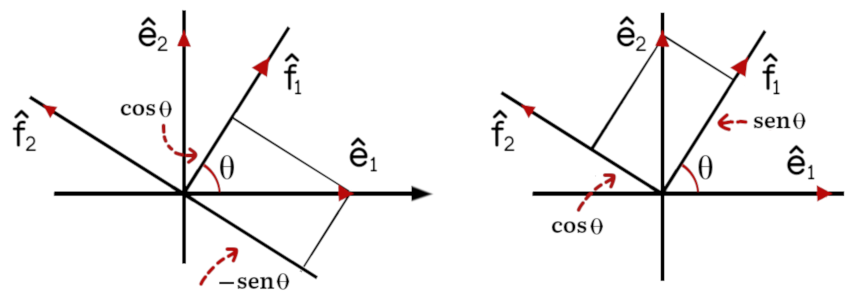

Outra operação importante é a de se encontrar autovetores e autovalores de uma matriz quadrada. Ele consiste em encontrar os valores de \(\lambda\) (os autovalores) e os autovetores \(x\) que satisfazem à equação \(A.x = \lambda x\). Se consideramos a matriz \(A\) como a matriz correspondente a uma transformação linear então os autovetores são aquelas direções mantidas invariantes pela transformação e \(\lambda\) (os autovalores) são os fatores de escala nestas direções.

Por exemplo, no plano uma reflexão no eixo \(Ox\) corresponde à transformação \(R_x(x,y)=(x, -y)\). Ela pode ser escrita em forma matricial como

$$

r_x \left[ \begin{array}{r}

x\\

y

\end{array} \right] = \left[ \begin{array}{rr}

1 & 0\\

0 & – 1

\end{array} \right] \left[ \begin{array}{r}

x\\

y

\end{array} \right] = \left[ \begin{array}{r}

x\\

– y

\end{array} \right].

$$

Portanto queremos encontrar os autovetores e autovalores do array reflex:

» # a reflexão em Ox é descrita por

» reflx = np.array([[1, 0],[0,-1]])

» reflx

↳ array([[ 1, 0],

[ 0, -1]])

» # seus autovalores e autovetores são

» auto = eig(reflx)

» auto

↳ (array([ 1., -1.]),

↳ array([[1., 0.],

[0., 1.]]))

» # eig retorna um tupla com 2 elementos

» # o primeiro contem outra tupla com os autovalores (1, -1)

» auto[0]

↳ array([ 1., -1.])

» # o segundo contém outra tupla com os dois autovetores

» auto[1]

↳ array([[1., 0.],

[0., 1.]])

» auto[1][0]

↳ array([1., 0.])

» auto[1][1]

↳ array([0., 1.])

Isso significa que no plano, a reflexão em torno do eixo \(Ox\) só deixa 2 direções inalteradas: a direção de x, sendo que todos os vetores \((x,0)\) ficam iguais (autovalor = 1), e o eixo \(Oy\). Vetores \((0,y)\) permanecem na mesa direção com o sentido invertido (autovalor = -1).

Brodcasting

Broadcasting se refere ao comportamento de arrays de diferentes dimensões quando operados entre si. Quando uma ou mais dimensões estão ausentes em um dos arrays e as dimensões presentes são compatíveis o array menor e replicado para preencher as dimensões ausentes de forma a que ambas tenham as mesmas dimensões.

Na figura a operação de soma é mostrada. O mesmo comportamento se dá para qualquer outras operação.

Bibliografia

- Harrison, Matt: Learning Pandas, Python Tools for Data Munging, Data Analysis, and Visualization,

Treading on Python Series, Prentiss, 2016. - McKinney, Wes: Python for Data Analysis, O’Reilly Media, Sebastopol CA, 2018.

- McKinney, Wes & Pandas Development Team: pandas: powerful Python data analysis toolkit Release 1.2.1,

- Miller, Curtis: Hands-On Data Analysis with NumPy and pandas, Packt Publishing, Birmingham, 2018.

- NumPy, docs.

- NumPy, Learn.

- NumPy, linalg.

Sobre Sympy: Matemática Simbólica em Python

- Scipy Lecture Notes: Sympy: Simbolic mathematics in Python, acessado em agosto de 2021.

- Purdue Science: Sympy: Simbolic mathematics in Python, acessado em agosto de 2021.

Nesse site: