Matrizes

Definição: Uma matriz é uma coleção de elementos estabelecidos em linhas e colunas, da seguinte forma:

$$

A_{m \times n} = \left[ \begin{array}{llll}

a_{11} & a_{12} & \cdots & a_{1 n} \\

a_{21} & a_{22} & \cdots & a_{2 n} \\

\vdots & & & \vdots \\

a_{m 1} & a_{m 2} & \cdots & a_{m n}

\end{array} \right],

$$

onde \(a_{i j} \) representa o elemento na \(i\)-ésima linha e \(j\) -ésima coluna. A matriz acima, portanto, tem \(m\) linhas e \(n\) colunas e dizemos que esta matriz tem dimensão \(m \times n\) . Como delimitadores de uma matriz podemos usar colchetes [ ] ou parênteses ( ), de acordo com a conveniência. Também podemos representar uma matriz por meio de um elemento genérico, colocado entre colchetes para indicar que se trata de uma coleção de linhas e coluna, na forma de

$$

A_{m \times n} = \{a_{i j} \},\;\; i = 1, \ldots, m, j = 1, \ldots, n,

$$

e, em algumas situações, nos referiremos a um elemento genérico da matriz \(A\) por \((A)_{i j} = a_{i j}\) . Os exemplos dados abaixo servirão para ilustrar este conceito e apresentar algumas matrizes de tipos mais comuns e mais utilizadas.

Exemplo: A matriz \(A\) abaixo é uma matriz \(2 \times 2\) , portanto uma matriz quadrada,

$$

A = \left[ \begin{array}{ll}

1 & 3\\

4 & 5

\end{array} \right],

$$

onde os elementos \(a_{11} = 1\) , \(a_{22} = 5\) , só para citar alguns exemplos. A matriz

$$

B = \left[ \begin{array}{ll}

1 & – 2\\

3 & \;0\\

5 & \;4

\end{array} \right]

$$

é uma matriz \(3 \times 2\) (ou seja, tem 3 linhas e duas colunas) enquanto \(C = [1]\) é uma matriz \(1 \times 1\) . Matrizes \(n \times 1\) são denominadas matrizes colunas, tais como \(D_{4 \times 1}\) abaixo

$$

D = \left[ \begin{array}{l}

2\\

0\\

1\\

3

\end{array} \right],

$$

enquanto matrizes \(1 \times n\) são denominadas matrizes linhas, tais como \(E = [1, 2, 6] .\) Uma matriz nula possue todos os seus componentes nulos,

$$

F = \left[ \begin{array}{ll}

0 & 0\\

0 & 0

\end{array} \right] .

$$

Podemos usar o símbolo \(\tilde{0}\) para representar a matriz nula quando isto for interessante para a discussão do momento. Uma matriz identidade é uma matriz quadrada com todos os elementos nulos exceto os da diagonal principal, que são de uma unidade, como \(\mathbb{I}_{3 \times 3}\) abaixo,

$$

\mathbb{I}= \left[ \begin{array}{lll}

1 & 0 & 0\\

0 & 1 & 0\\

0 & 0 & 1

\end{array} \right] .

$$

Observe que \(\mathbb{I}\) (ou outra matriz identidade de qualquer dimensão) tem elementos

$$

(I)_{i j} = \delta_{i j} = \left\{ \begin{array}{ll}

1 & \text{se } i = j,\\

0 & \text{se} i \neq j.

\end{array} \right.

$$

O símbolo \(\delta\) definido desta forma é o chamado delta de Kronecker. Logo ficará claro porque chamamos esta matriz de identidade. E interessante ainda definir as matrizes diagonais como aquelas que possuem todos os elementos nulos exceto os da diagonal principal, que podem ter qualquer valor, como

\begin{eqnarray*}

& & G = \left[ \begin{array}{lll}

7 & 0 & 0\\

0 & – 1 & 0\\

0 & 0 & 1

\end{array} \right],

\end{eqnarray*}

e as matrizes simétricas, que são aquelas que permanecem inalteradas quando suas linhas são tomadas como colunas, tal como

$$

H = \left[ \begin{array}{lll}

3 & 2 & 1\\

2 & 0 & 7\\

1 & 7 & 1

\end{array} \right] .

$$

Alternativamente, definimos a matriz \(H = \{h_{i j} \}\) como simétrica se \(h_{i j} = h_{j i}\) .

Definição: Se \(A\) é uma matriz \(n \times m\) sua transposta e a matriz \(A’_{m \times n} \) obtida de \(A\) por meio da transposição de suas linhas em colunas, \((A)_{i j} = (A’)_{j i}\) .

Exemplo: A transposta da matriz \(B\) acima é

$$

B’ = \left[ \begin{array}{ccc}

1 & 3 & 5\\

– 2 & 0 & 4

\end{array} \right] .

$$

As seguintes propriedades podem ser verificadas quanto à transposição de matrizes:

(i) Se \(S\) é uma matriz simétrica então \(S’ = S\) ,ou seja, uma matriz simétrica é igual a sua transposta.

(ii) \(A’ ‘ = A\) ,

(iii) \((A + B)’ = A’ + B’\) ,

(iv) \((k A)’ = k A’\) .

Definição: dizemos que duas matrizes são iguais se, e somente se, tem a mesma ordem e todos os seus elementos correspondentes (na mesma linha e mesma coluna) são iguais;

$$

A = B \Leftrightarrow a_{i j} = b_{i j.}

$$

A álgebra das Matrizes

Tendo definido as matrizes podemos agora definir uma álgebra ou um conjunto de operações sobre estes elementos.

1) Adição: Se \(A\) e \(B\) são matrizes de mesma ordem então \((A + B)_{i j} = a_{i j} + b_{i j}\) .

Exemplo .

$$

\left[ \begin{array}{lll}

1 & 3 & 5\\

– 2 & 0 & 4

\end{array} \right] + \left[ \begin{array}{lll}

1 & 4 & 1\\

2 & 3 & 3

\end{array} \right] = \left[ \begin{array}{lll}

2 & 7 & 6\\

0 & 3 & 7

\end{array} \right] .

$$

As seguintes propriedades são válidas para a operação de adição: se \(A\) e \(B\) são matrizes de mesma ordem então

(i) \(A + B = B + A\) ,

(ii) \(A + (B + C) = (A + B) + C\) (associatividade),

2) Multiplicação por escalar: Se \(A_{m \times n}\) é uma matriz e \(k\) é um número (um escalar) então

$$

(k \cdot A)_{i j} = k a_{i j.}

$$

Exemplos:

$$

– 2 \left[ \begin{array}{ll}

– \frac{1}{2} & \frac{3}{2}\\

& \\

– 1 & 2

\end{array} \right] = \left[ \begin{array}{ll}

1 & – 3\\

& \\

2 & – 4

\end{array} \right],

$$

$$

\left[ \begin{array}{lll}

3 & 0 & 0\\

0 & 3 & 0\\

0 & 0 & 3

\end{array} \right] = 3\mathbb{I}_{3 \times 3},

$$

onde \(\mathbb{I}_{3 \times 3}\) é a matriz identidade .

As seguintes propriedades são válidas para as operações já consideradas: se \(A\) e \(B\) são matrizes de mesma ordem, \(k\) e \(l \) são escalares então:

(i) \(k (A + B) = k A + k B\) ;

(ii) \((k + l) A = k A + l A\) ;

(iii) \(0 \cdot A = \tilde{0}\) ;

(iv) \(k (l A) = (k l) A\) .

Observe na propriedade (iii) que o produto de qualquer matriz pelo escalar \(0\) é a matriz nula \(\tilde{0}\) embora seja costume representar este resultado simplesmente pelo número 0. Um outro exemplo onde isto pode ocorrer é o seguinte

$$

\left[ \begin{array}{ll}

3 & 2\\

1 & 3

\end{array} \right] – \left[ \begin{array}{ll}

3 & 2\\

1 & 3

\end{array} \right] = 0,

$$

onde o resultado escrito como 0 por abuso de linguagem, na verdade significa a matriz \(\tilde{0}\) de dimensões \(2 \times 2\) .

3) Multiplicação de matrizes

Dadas as matrizes \(A_{m \times n}\) e \(B_{n \times p}\) (notando portanto que \(B\) tem um número de linhas igual ao número de colunas de \(A\) ) definimos o produto de \(A\) por \(B\) da seguinte forma

$$

(A B)_{i j} = \sum^n_{k = 1} a_{i k} b_{k j} .

$$

Isto significa que o elemento da \(i\) -ésima linha e \(j\) -ésima coluna é obtido pela soma dos produtos de elementos da \(i\) -ésima linha de \(A\) com a \(j\) -ésima coluna de \(B\) . O produto é a matriz \(A B\) de dimensões \(m \times p\) . Alguns exemplos servirão para esclarecer este procedimento. No entanto é útil compreender a operação indicada simbolicamente pelo somatório acima.

Exemplos: (1)

$$

\left[ \begin{array}{ccc}

1 & 0 & 2\\

3 & 1 & – 1\\

0 & 1 & 4

\end{array} \right] \left[ \begin{array}{c}

1\\

– 1\\

2

\end{array} \right] = \left[ \begin{array}{l}

5\\

0\\

7

\end{array} \right] .

$$

O elemento da linha 1 e coluna 1 do produto foi obtido da seguinte forma: \(1 \times 1 + 0 (- 1) + 2 \times 2 = 5.\)

(2)

$$

\left[ \begin{array}{ll}

2 & – 2\\

1 & 0\\

0 & – 1

\end{array} \right] \left[ \begin{array}{lll}

1 & 3 & 0\\

2 & – 1 & 1

\end{array} \right] = \left[ \begin{array}{lll}

– 2 & 8 & – 2\\

1 & 3 & 0\\

– 2 & 1 & – 1

\end{array} \right] .

$$

(3)

$$

\left[ \begin{array}{ll}

2 & 1\\

4 & 2\\

5 & 3

\end{array} \right] \left[ \begin{array}{ll}

1 & – 1\\

0 & 4

\end{array} \right] = \left[ \begin{array}{ll}

2 & 2\\

4 & 4\\

5 & 7

\end{array} \right] .

$$

(4) Observe que, em geral, o produto de matrizes é não-comutativo, ou seja, \(A B \neq B A\) :

$$

A = \left[ \begin{array}{lll}

1 & – 1 & 1\\

– 3 & 2 & – 1\\

– 2 & 1 & 0

\end{array} \right] ; B = \left[ \begin{array}{lll}

1 & 2 & 3\\

2 & 4 & 6\\

1 & 2 & 3

\end{array} \right] ;

$$

$$

A B = \left[ \begin{array}{lll}

0 & 0 & 0\\

0 & 0 & 0\\

0 & 0 & 0

\end{array} \right] ; B A = \left[ \begin{array}{lll}

– 11 & 6 & – 1\\

– 22 & 12 & – 2\\

– 11 & 6 & – 1

\end{array} \right] .

$$

Neste último exemplo observamos que, além da não co mutatividade do produto de matrizes, é possível que o produto de duas matrizes seja nulo sem que nenhuma delas seja a matriz nula.

Propriedades do produto de matrizes

(i) \(A B \neq B A\) ,

(ii) \(A\mathbb{I}=\mathbb{I}A = A\) , onde \(\mathbb{I}\) é a matriz identidade (e dai o seu nome),

(iii) \(A (B + C) = A B + A C\) ,(distributividade à esquerda),

(iv) \((B + C) A = B A + C A\) , (distributividade à direita),

(v) \((A B) C = A (B C)\) , (associatividade),

(vi) \((A B)’ = B’ A’\) ,

(vii) \(\tilde{0} A = A \tilde{0} = \tilde{0}\) , onde \(\tilde{0}\) é a matriz nula.

Sistemas de equações lineares

Definição: Um sistema com \(m\) equações lineares com \(n\) incógnitas é um conjunto de equações da forma de

\begin{eqnarray*}

a_{11} x_1 + a_{12} x_2 + \ldots + a_{1 n} x_n = b_1 & & \\

a_{21} x_1 + a_{22} x_2 + \ldots + a_{2 n} x_n = b_2 & & \\

\vdots & & \\

a_{m 1} x_1 + a_{m 2} x_2 + \ldots + a_{m n} x_n = b_m & &

\end{eqnarray*}

onde \(a_{i j}, 1 \leq i \leq m, 1 \leq j \leq n,\) são números reais (ou complexos) e \(x_k, 1 \leq k \leq n\) são \(n\) incógnitas. Uma solução do sistema acima, quando existir, é uma \(n\) -upla \((x_1, x_2, \ldots, x_n)\) que satisfaz simultaneamente as \(m\) equações do sistema. Podemos escrever o mesmo sistema sob forma matricial

$$

\left[ \begin{array}{llll}

a_{11} & a_{12} & \cdots & a_{1 n}\\

a_{21} & a_{22} & \cdots & a_{2 n}\\

\vdots & & & \vdots\\

a_{m 1} & a_{m 2} & \cdots & a_{m n}

\end{array} \right] \left[ \begin{array}{l}

x_1\\

x_2\\

\vdots\\

x_n

\end{array} \right] = \left[ \begin{array}{l}

b_1\\

b_2\\

\vdots\\

b_m

\end{array} \right],

$$

ou simplesmente

$$

A X = B

$$

onde

$$

A = \left[ \begin{array}{llll}

a_{11} & a_{12} & \cdots & a_{1 n}\\

a_{21} & a_{22} & \cdots & a_{2 n}\\

\vdots & & & \vdots\\

a_{m 1} & a_{m 2} & \cdots & a_{m n}

\end{array} \right], X = \left[ \begin{array}{l}

x_1\\

x_2\\

\vdots\\

x_n

\end{array} \right], B = \left[ \begin{array}{l}

b_1\\

b_2\\

\vdots\\

b_m

\end{array} \right],

$$

sendo que \(A\) é denominada matriz dos coeficientes do sistema, \(X\) é a matriz das incógnitas e \(B\) a matriz dos termos constantes. Alternativamente é útil escrever o mesmo sistema como o conjunto das equações

\begin{eqnarray*}

\sum_{j = 1}^n a_{1 j} x_j = b_{1,} & & \\

\sum_{j = 1}^n a_{2 j} x_j = b_{2,} & & \\

\vdots & & \\

\sum_{j = 1}^n a_{m j} x_j = b_{m,} & &

\end{eqnarray*}

ou, de modo compacto,

$$

\sum_{j = 1}^n a_{i j} x_j = b_{i,} 1 \leq i \leq m.

$$

Embora todas estas formas de se escrever o sistema de equações sejam equivalentes, é útil compreender cada uma delas. A notação de somatório é poderosa, principalmente para demonstrações e considerações teóricas sobre este e muitos outros tópicos.

Sistemas lineares aparecem em um grande número de aplicações e é necessário que se aprenda técnicas para encontrar suas soluções. Para isto apresentamos as definições abaixo.

Definição: A matriz ampliada associada ao sistema acima é

$$

\left[ \begin{array}{llll}

a_{11} & a_{12} & \cdots & a_{1 n}\\

a_{21} & a_{22} & \cdots & a_{2 n}\\

\vdots & & & \vdots\\

a_{m 1} & a_{m 2} & \cdots & a_{m n}

\end{array} \middle| \begin{array}{l}

b_1\\

b_2\\

\vdots\\

b_m

\end{array}]. \right.

$$

É usual, mas não obrigatório, o uso da barra de separação entre os termos \(a_{i j}\) e \(b_k\) .

Definição: Dois sistemas de equações lineares são ditos equivalentes se, e somente se, toda a solução de um deles é igualmente solução do outro.

Podemos obter sistemas equivalentes por meio das chamadas operações elementares:

(i) permutação de duas equações;

(ii) multiplicação de um das equações por um escalar;

(iii) substituição de uma das equações por sua soma com outra das equações do sistema.

Em termos das matrizes ampliadas associadas ao sistema estas mesmas operações significam as operações elementares sobre as linhas desta matriz. Exemplificando estas operações elementares sobre linhas de uma matriz temos:

(i) Permutação de linhas: \(L_i \leftrightarrow L_j\) ,

$$

\left[ \begin{array}{ll}

1 & 2\\

3 & 4\\

5 & 6

\end{array} \right] L_1 \leftrightarrow L_2 \left[ \begin{array}{ll}

3 & 4\\

1 & 2\\

5 & 6

\end{array} \right] .

$$

(ii) Multiplicação de uma linha por um escalar: \(k L_i \rightarrow L_i\),

$$

\left[ \begin{array}{ll}

3 & 4\\

1 & 2\\

5 & 6

\end{array} \right] 3 L_2 \rightarrow L_2 \left[ \begin{array}{ll}

3 & 4\\

3 & 6\\

5 & 6

\end{array} \right] .

$$

(iii) Substituição de uma linha por sua soma com outra linha: \(L_i + L_j \rightarrow L_i\),

$$

\left[ \begin{array}{ll}

3 & 4\\

3 & 6\\

5 & 6

\end{array} \right] L_1 + L_2 \rightarrow L_1 \left[ \begin{array}{ll}

6 & 10\\

3 & 6\\

5 & 6

\end{array} \right] .

$$

Definição: Duas matrizes são equivalentes se uma pode ser obtida da outra por meio de um número finito de operações elementares. Denotaremos a equivalência entre duas matrizes \(A\) e \(B\) por meio do símbolo \(A \sim B\) .

Definição: uma matriz está em sua forma linha reduzida à forma escada se

- O primeiro elemento de cada linha é 1. Chamaremos de piloto a este elemento.

- Cada coluna que possue um elemento piloto de alguma das linhas contém todos os demais elementos nulos.

- O piloto de cada linha ocorre em colunas progressivas.

- Linhas inteiramente nulas ocorrem abaixo de todas as demais.

A matriz reduzida à sua forma escada terá a forma indicada na figura.

Uma vez que as operações elementares sobre um sistema de equações lineares não alteram a solução do sistema, e que matrizes equivalentes são obtidas uma da outra por meio de operações elementares sobre suas linhas, podemos concluir que dois sistemas cujas matrizes ampliadas são equivalentes possuem a mesma solução ou soluções, quando estas existirem. Isto nos permite enunciar um método de solução.

Método de Gauss-Jordan para solução de sistema lineares

O método de Gauss-Jordan consiste no seguinte procedimento:

- Dado um sistema de equações lineares começamos por escrever a sua matriz ampliada associada.

- Através de operações elementares sobre linhas da matriz ampliada obtemos a matriz equivalente reduzida à forma escada.

- A matriz equivalente reduzida à forma escada será associada a um sistema onde a solução do sistema original é de fácil leitura.

Vamos ilustrar estas operações elementares por meio de um exemplo. Nele indicaremos as operações realizadas sobre as linhas de uma matriz amplida apenas para efeito de acompanhanto do leitor. A operação \(L_1 + L_2 \rightarrow L_2\) , por exemplo, significa: substitua a linha 2 pela soma da linha 2 com a linha 1.

Exemplo . O sistema

\begin{eqnarray*}

x + 4 y + 3 z = 1 & & \\

2 x + 5 y + 4 z = 4 & & \\

x – 3 y – 2 z = 5 & &

\end{eqnarray*}

pode ser representado matricialmente por

$$

\left[ \begin{array}{lll}

1 & 4 & 3\\

2 & 5 & 4\\

1 & – 3 & – 2

\end{array} \right] \left[ \begin{array}{l}

x\\

y\\

z

\end{array} \right] = \left[ \begin{array}{l}

1\\

4\\

5

\end{array} \right]

$$

que corresponde à matriz ampliada

$$

M = \left[ \begin{array}{lll}

1 & 4 & 3\\

2 & 5 & 4\\

1 & – 3 & – 2

\end{array} \begin{array}{l}

1\\

4\\

5

\end{array} \right] .

$$

As seguintes operações elementares podem ser efetuadas para obter sistemas equivalentes:

\begin{eqnarray*}

& & \left[ \begin{array}{lll}

1 & 4 & 3\\

2 & 5 & 4\\

1 & – 3 & – 2

\end{array} \begin{array}{l}

1\\

4\\

5

\end{array} \right] \begin{array}{l}

2 L_1 – L_2 \rightarrow L_2\\

L_1 – L_3 \rightarrow L_3

\end{array} \rightarrow \left[ \begin{array}{lll}

1 & 4 & 3\\

0 & 3 & 2\\

0 & 7 & 5

\end{array} \begin{array}{l}

1\\

– 2\\

– 4

\end{array} \right] \begin{array}{l}

\frac{1}{3} L_2 \rightarrow L_2

\end{array} \rightarrow \left[ \begin{array}{lll}

1 & 4 & 3\\

0 & 1 & 2 / 3\\

0 & 7 & 5

\end{array} \begin{array}{l}

1\\

– 2 / 3\\

– 4

\end{array} \right]\\

& & \\

& & \begin{array}{l}

L_1 – 4 L_2 \rightarrow L_1\\

L_3 – 7 L_2 \rightarrow L_3

\end{array} \left[ \begin{array}{lll}

1 & 0 & 1 / 3\\

0 & 1 & 2 / 3\\

0 & 0 & 1 / 3

\end{array} \begin{array}{l}

11 / 3\\

– 2 / 3\\

2 / 3

\end{array} \right] \begin{array}{l}

3 L_3 \rightarrow L_3

\end{array} \left[ \begin{array}{lll}

1 & 0 & 1 / 3\\

0 & 1 & 2 / 3\\

0 & 0 & 1

\end{array} \begin{array}{l}

11 / 3\\

– 2 / 3\\

2

\end{array} \right]\\

& & \\

& & \begin{array}{l}

– 1 : 3 L_3 + L_1 \rightarrow L_1\\

L_2 – 2 : 3 L_3 \rightarrow L_2

\end{array} \left[ \begin{array}{lll}

1 & 0 & 0\\

0 & 1 & 0\\

0 & 0 & 1

\end{array} \begin{array}{l}

3\\

– 2\\

2

\end{array} \right] .

\end{eqnarray*}

A última linha contém a matriz reduzida à forma escada e associada ao sistema

$$

\left. \begin{array}{ll}

x + 0 y + 0 z = 3 & \\

0 x + y + 0 z = – 2 & \\

0 x + 0 y + z = 2 &

\end{array} \right\} \Rightarrow x = 3, y = – 2, z = 2,

$$

que é a solução do sistema inicial, como pode ser verificado por substituição direta.

Exercício resolvido: resolva o sistema

\begin{eqnarray*}

x + 2 y + 3 z = 9 & & \\

2 x – y + z = 8 & & \\

3 x – z = 3. & &

\end{eqnarray*}

A matriz ampliada associada a este sistema é

$$

A = \left[ \begin{array}{lll}

1 & 2 & 3\\

2 & – 1 & 1\\

3 & 0 & – 1

\end{array} \begin{array}{l}

9\\

8\\

3

\end{array} \right] .

$$

Através de operações elementares sobre as linhas desta matriz procuramos colocá-la gradualmente sob a forma escada:

\begin{eqnarray*}

\begin{array}{lllll}

A = & \left[ \begin{array}{l}

\begin{array}{lll}

1 & 2 & 3\\

2 & – 1 & 1\\

3 & 0 & – 1

\end{array} \begin{array}{l}

9\\

8\\

3

\end{array}

\end{array} \right] & \sim & \left[ \begin{array}{l}

\begin{array}{lll}

1 & 2 & 3\\

0 & – 5 & – 5\\

0 & – 6 & – 10

\end{array} \begin{array}{l}

9\\

– 10\\

– 24

\end{array}

\end{array} \right] \sim & \left[ \begin{array}{l}

\begin{array}{lll}

1 & 2 & 3\\

0 & 1 & 1\\

0 & 3 & 5

\end{array} \begin{array}{l}

9\\

2\\

12

\end{array}

\end{array} \right] \sim\\

& & & & \\

& L_2 – 2 L_1 \rightarrow L_2 \{p_1 \} & & L_2 / (- 5) \rightarrow L_2

\{p_3 \} & L_1 – 2 L_2 \rightarrow L_1 \{p_5 \}\\

& L_3 – 3 L_1 \rightarrow L_3 \{p_2 \} & & L_3 / (- 2) \rightarrow

L_3 \{p_4 \} & L_3 – 3 L_2 \rightarrow L_3 \{p_6 \}

\end{array} & &

\end{eqnarray*}

\begin{eqnarray*}

\begin{array}{lllll}

\sim & \left[ \begin{array}{l}

\begin{array}{lll}

1 & 0 & 1\\

0 & 1 & 1\\

0 & 0 & 2

\end{array} \begin{array}{l}

5\\

2\\

6

\end{array}

\end{array} \right] & \sim & \left[ \begin{array}{l}

\begin{array}{lll}

1 & 0 & 1\\

0 & 1 & 1\\

0 & 0 & 1

\end{array} \begin{array}{l}

5\\

2\\

3

\end{array}

\end{array} \right] \sim & \left[ \begin{array}{l}

\begin{array}{lll}

1 & 0 & 0\\

0 & 1 & 0\\

0 & 0 & 1

\end{array} \begin{array}{l}

2\\

– 1\\

3

\end{array}

\end{array} \right],\\

& & & & \\

& L_3 / 2 \rightarrow L_3 \{p_7 \} & & L_1 – L_3 \rightarrow L_1

\{p_8 \} & \\

& & & L_2 – L_3 \rightarrow L_2 \{p_9 \} &

\end{array} & &

\end{eqnarray*}

sendo que esta última matriz se encontra em sua forma reduzida e representa a solução do sistema \(x = 1, y = – 1, z = 3\) .

\(\{p_1 \}\) zeramos o elemento na coluna 1, onde ocorre o piloto da primeira linha;

\(\{p_2 \}\) idem para a linha 3;

\(\{p_3 \}\) introduzimos o piloto da linha 2;

\(\{p_4 \}\) apenas uma simplificação para os cálculos posteriores;

\(\{p_5 \}\) zeramos \(a_{12}\) ;

\(\{p_6 \}\) zeramos \(a_{32}\) ;

\(\{p_7 \}\) introduzimos o piloto da linha 3;

\(\{p_8 \}\) zeramos \(a_{13}\) ;

\(\{p_9 \}\) zeramos \(a_{23}\) . O procedimento é interrompido porque atingimos a matriz equivalente na forma reduzida .

é claro que não existe uma única forma para se atingir a matriz na forma escada e, algumas vezes, uma escolha apropriada de passos pode reduzir muito o trabalho necessário para atingí-la. No entanto, se um passo mais hábil ou mais rápido não for percebido, podemos executar etapas intermediárias que facilitem este processo. Para quem está aprendendo a operação pode ser preferível realizar um número maior de passos e um de cada vez.

Algumas vezes é necessário saber se existem uma ou mais soluções para um sistema linear. As definições dadas a seguir nos permitem obter esta informação mesmo sem resolvê-lo.

Definição: Seja \(A_{m \times n}\) uma matriz e \(B_{m \times n}\) sua matriz equivalente reduzida à forma escada. \(p\) ,o posto de \(A\) , é o número de linhas não nulas de \(B\) . A nulidade de \(A\) é igual ao número de colunas menos o posto, \(n – p\) .

Exemplo . Qual é o posto e a nulidade da matriz \(A\) dada abaixo?

$$

\begin{array}{ll}

A = & \left[ \begin{array}{l}

\begin{array}{llll}

1 & 2 & 1 & 0\\

– 1 & 0 & 3 & 5\\

1 & – 2 & 1 & 1

\end{array}

\end{array} \right] .

\end{array}

$$

Buscamos, por meio das operações elementares sobre as linhas de \(A\) encontrar sua equivalente reduzida à forma escada. Começaremos com os passos \(L_1 + L_2 \rightarrow L_2\) e \(L_1 – L_3 \rightarrow L_3\) :

\begin{eqnarray*}

\begin{array}{lllll}

A \sim & \left[ \begin{array}{l}

\begin{array}{llll}

1 & 2 & 1 & 0\\

0 & 2 & 4 & 5\\

0 & 4 & 0 & – 1

\end{array}

\end{array} \right] & \sim & \left[ \begin{array}{l}

\begin{array}{llll}

1 & 2 & 1 & 0\\

0 & 1 & 2 & 5 / 2\\

0 & 0 & – 8 & – 11

\end{array}

\end{array} \right] \sim & \left[ \begin{array}{l}

\begin{array}{llll}

1 & 2 & 1 & 0\\

0 & 1 & 2 & 5 / 2\\

0 & 0 & 1 & 11 / 8

\end{array}

\end{array} \right] \sim\\

& & & & \\

& L_2 / 2 \rightarrow L_2 & & – L_3 / 8 \rightarrow L_3 & L_1 – 2

L_2 \rightarrow L_1\\

& L_3 – 2 L_2 \rightarrow L_3 & & & L_2 – 2 L_3 \rightarrow L_2

\end{array} & &

\end{eqnarray*}

\begin{eqnarray*}

\begin{array}{lllll}

\sim & \left[ \begin{array}{l}

\begin{array}{llll}

1 & 0 & – 3 & – 5\\

0 & 1 & 0 & – 1 / 4\\

0 & 0 & 1 & 11 / 8

\end{array}

\end{array} \right] & \sim & \left[ \begin{array}{llll}

1 & 0 & 0 & – 7 / 8\\

0 & 1 & 0 & – 1 / 4\\

0 & 0 & 1 & 11 / 8

\end{array} \right] & = B,\\

& & & & \\

& L_1 + 3 L_2 \rightarrow L_1 & & &

\end{array} & &

\end{eqnarray*}

sendo que a matriz \(B\) está em sua reduzida. O posto de \(A\) é \(p = 3\) porque \(B\) tem 3 linhas não nulas. Como \(A\) tem \(n = 4\) colunas, a nulidade de \(A\) é \(n – p = 1\) .

Exercício resolvido: Encontre o posto e a nulidade de

$$

\begin{array}{ll}

B = & \left[ \begin{array}{lll}

2 & – 1 & 3\\

1 & 4 & 2\\

1 & – 5 & 1\\

4 & 16 & 8

\end{array} \right] .

\end{array}

$$

\begin{eqnarray*}

\begin{array}{lllll}

B \sim & \left[ \begin{array}{lll}

1 & 4 & 2\\

2 & – 1 & 3\\

1 & – 5 & 1\\

1 & 4 & 2

\end{array} \right] & \sim & \left[ \begin{array}{lll}

1 & 4 & 2\\

0 & – 9 & – 1\\

1 & – 9 & – 1\\

0 & 0 & 0

\end{array} \right] \sim & \left[ \begin{array}{lll}

1 & 4 & 2\\

0 & 1 & 1 / 9\\

0 & 0 & 0\\

0 & 0 & 0

\end{array} \right] \sim\\

& L_2 – 2 L_1 \rightarrow L_2 & & & \\

L_1 \leftrightarrow L_2 & L_3 – L_1 \rightarrow L_3 & & L_2 / (- 9)

\rightarrow L_2 & L_1 – 4 L_2 \rightarrow L_1\\

L_4 / 4 \rightarrow L_4 & L_4 – L_1 \rightarrow L_4 & & L_3 – L_2

\rightarrow L_3 &

\end{array} & &

\end{eqnarray*}

\begin{eqnarray*}

\begin{array}{lll}

\sim & \left[ \begin{array}{lll}

1 & 0 & 14 / 9\\

0 & 1 & 1 / 9\\

0 & 0 & 0\\

0 & 0 & 0

\end{array} \right] = C & .

\end{array} & &

\end{eqnarray*}

sendo que a matriz \(B\) está em sua reduzida. O posto de \(A\) é \(p = 3\) porque \(B\) tem 3 linhas não nulas. Como \(A\) tem \(n = 4\) colunas, a nulidade de \(A\) é \(n – p = 1\) .

Continuando com a questão da existência de soluções vamos examinar alguns casos ilustrativos de sistemas e suas soluções.

(1) Sistema trivial, com uma incógnita e uma equação

$$

a x = b.

$$

Os seguintes casos podem ocorrer:

- Se \(a \neq 0\) então existe uma única solução, \(x = b / a\) .

- Se \(a = 0\) e \(b = 0\) o sistema é \(0 x = 0\), satisfeito por qualquer valor de \(x\) . Existem, portanto, infinitas soluções.

- Se \(a = 0\) e \(b \neq 0\) o sistema \(0 x = b\) , não é satisfeito por nenhum valor de \(x\) , ou seja, não existem soluções.

(2) Sistema com uas equações e duas incógnitas.

Exemplo:

$$

\left\{ \begin{array}{l}

2 x + y = 5\\

x – 3 y = 6

\end{array} \right.

$$

Embora este seja um sistema de fácil solução por meio de uma simples substituição, para efeito de exercício da técnica aprendida, escrevemos matriz ampliada e suas matrizes equivalentes,

\begin{eqnarray*}

\left[ \begin{array}{lll}

2 & 1 & 5\\

1 & – 3 & 6

\end{array} \right] \sim \left[ \begin{array}{lll}

1 & 1 / 2 & 5 / 2\\

1 & – 3 & 6

\end{array} \right] \sim \left[ \begin{array}{lll}

1 & 1 / 2 & 5 / 2\\

0 & 7 / 2 & – 7 / 2

\end{array} \right] \sim \left[ \begin{array}{lll}

1 & 1 / 2 & 5 / 2\\

0 & 1 & – 1

\end{array} \right] \sim \left[ \begin{array}{lll}

1 & 0 & 3\\

0 & 1 & – 1

\end{array} \right], & &

\end{eqnarray*}

ou seja, \(x = 3\) e \(y = – 1\) é a solução única do sistema. A

matriz dos coeficientes

\begin{eqnarray*}

\left[ \begin{array}{ll}

2 & 1\\

1 & – 3

\end{array} \right] \sim \left[ \begin{array}{ll}

1 & 0\\

0 & 1

\end{array} \right] & &

\end{eqnarray*}

tem posto 2 enquanto a matriz ampliada também tem posto 2. Lembramos ainda que \(n = 2\) é o número de incógnitas envolvidas. Como se pode ver na figura cada equação do sistema corresponde a uma reta do plano e a solução é dada pelo único ponto comum entre elas.

Exemplo 2:

$$

\left\{ \begin{array}{l}

2 x + y = 5\\

6 x + 3 y = 15

\end{array} \right.

$$

A matriz ampliada e suas matrizes equivalentes são, por exemplo,

\begin{eqnarray*}

\left[ \begin{array}{lll}

2 & 1 & 5\\

6 & 3 & 15

\end{array} \right] \sim \left[ \begin{array}{lll}

1 & 1 / 2 & 5 / 2\\

0 & 0 & 0

\end{array} \right], & &

\end{eqnarray*}

indicando que existem infinitas soluções, que são todos os pontos da reta \(x + y / 2 = 5 / 2\) . Observamos que as duas equações do

sistema são uma múltiplo da outra e representam a mesma reta. A matriz dos coeficientes

\begin{eqnarray*}

\left[ \begin{array}{ll}

2 & 1\\

6 & 3

\end{array} \right] \sim \left[ \begin{array}{ll}

1 & 1 / 2\\

0 & 0

\end{array} \right] & &

\end{eqnarray*}

tem posto 1 e a matriz ampliada também tem posto 1. A nulidade de \(A\) é 2 enquanto a nulidade da matriz dos coeficientes é 1. Geometricamente as duas equações do sistema são repreentadas pela mesma (uma delas é meramente um múltiplo da outra) e todos os pontos que satisfazem a primeira equação satisfazem também a segunda.

Exemplo: O sistema

$$

\left\{ \begin{array}{l}

2 x + y = 5\\

6 x + 3 y = 10

\end{array} \right.

$$

pode ser resolvido da mesma forma; a matriz ampliada e sua reduzida são

\begin{eqnarray*}

A = \left[ \begin{array}{lll}

2 & 1 & 5\\

6 & 3 & 10

\end{array} \right] \sim \left[ \begin{array}{lll}

1 & 1 / 2 & 5 / 2\\

0 & 0 & – 5

\end{array} \right] \sim \left[ \begin{array}{lll}

1 & 1 / 2 & 0\\

0 & 0 & 1

\end{array} \right], & &

\end{eqnarray*}

que representam um sistema sem solução. O posto de \(A\) é 2 e o posto da matriz dos coeficientes é 1. Geometricamente as duas linhas são equações de retas são paralelas que, por isto, não possuem pontos comuns.

Relacionando o número de equações, incógnitas e o posto das matrizes ampliada e dos coeficientes temos o seguinte resultado:

Teorema: Dado um sistema de \(m\) equações e \(n\) incógnitas, denotamos por \(p_A \)o posto da matriz ampliada e \(p_C \) o posto da matriz dos coeficientes. Então

- A condição \(p_A = p_C\) é necessária e suficiente para que o sistema admita uma ou mais soluções;

- A condição \(p_A = p_C = n\) é necessária e suficiente para que o sistema admita uma única solução;

- Se \(p_A = p_C \lt n\) então o sistema pode ser resolvido para \(p\) incógnitas em função das \(n – p\) incógnitas restantes.

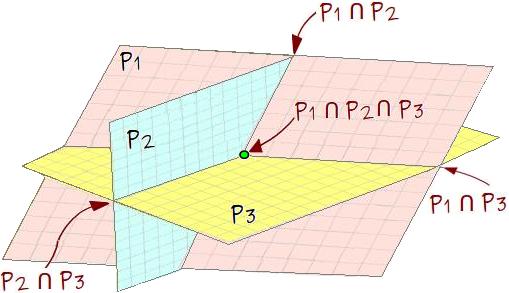

Sistema de três equações e três incógnitas: Cada uma das equações pode ser representada por um plano, P1, P2 e P3. Podem ocorrer, por exemplo, algumas dessas situações: (i) os planos são paralelos e não coincidentes; não existe nenhuma solução para o sistema; (ii) dois planos são coincidentes e interceptam o terceiro plano em uma reta. Neste caso existem infinitas soluções (os pontos da reta). (iii) Nenhum dos planos é paralelo a outro. Esta é a situação mostrada na figura 6 e existe uma única solução.